北京时间7月19日凌晨,美国OpenAI公司推出一款新的 AI 模型“GPT-4o mini”,即GPT-4o的更小参数量、简化版本。

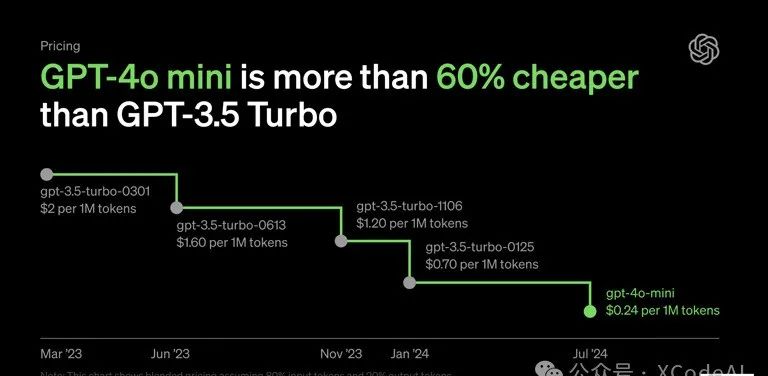

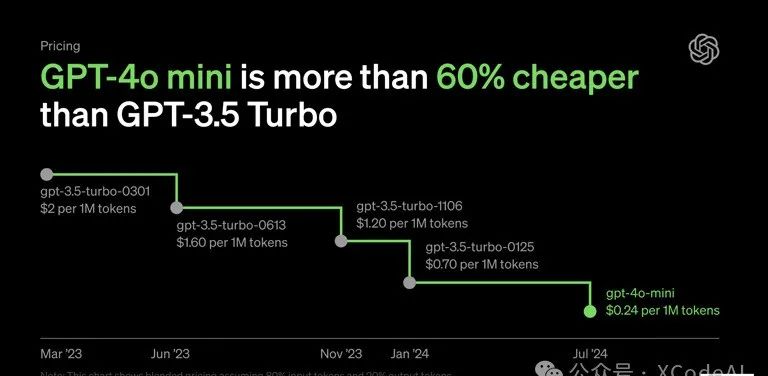

OpenAI表示,GPT-4o mini是目前功能最强大、性价比最高的小参数模型,性能逼近原版GPT-4,成本相比GPT-3.5 Turbo便宜60%以上,支持50种不同语言,替代GPT-3.5版本的ChatGPT,但该公司没有透露其训练参数规模信息。![]()

OpenAI表示,API层面,GPT-4o mini支持128k、16k输入tokens(图像和文本);价格层面,GPT-4o mini每百万输入tokens为15美分(约1.09元人民币),每百万输出tokens为60美分(约4.36元)。按照规划,GPT-4o mini即日起向ChatGPT免费用户以及 ChatGPT Plus和Team付费订阅用户开放,并将于下周向ChatGPT Enterprise企业版客户开放。另外,未来几天内,OpenAI还将开放GPT-4o mini微调版本。“推动我们可以免费提供 AI 技术的极限,是确保 AGI 造福全人类追求的一部分。”ChatGPT官方账号在社交平台上表示。OpenAI CEO奥尔特曼(Sam Altman)还透露,仅仅两年前,世界上最好的模型还是GPT-3的text-davinci-003版本,与今天相比表现差得多,还要贵上100倍。换句话来说,短短两年,GPT大模型每token的成本价格已经下降99%。根据 AIGCRank 维护的《国内外 AI 大语言模型 API 价格对比》榜单:

GPT-4o 每百万个输入 Token 的定价是 5 美元(人民币约为 36.3 元),输出是 15 美元(人民币约为 109 元);

百度文心 4.0 Turbo 的定价是输入 30 元、输出 60 元;

Claude 3 Haiku 的定价是输入是 0.25 美元(人民币约为 1.81 元)、输出 1.25 美元(人民币约为 9.08 元)。

价格差距

被认为引起国内大模型集体降价的「始作俑者」DeepSeek(深度求索),在与 Gemini 1.5 Flash 综合表现相近的情况下,API 定价(每百万个)可以做到输入 1 元、输出 2 元。阿里通义千问的 Qwen-Long,甚至还做到了输入 0.5 元、输出 2 元。对于开发者而言,「成本」和「效益」是大模型应用中最核心的两点。而更低的大模型价格,无疑有助于更多企业和个人开发者在更多场景、更多应用中引入生成式 AI,也有助于 AI 在普通人生活、工作中的普及,正如 Oliver Parker 强调的:我认为 GPT-4o Mini 真正体现了 OpenAI 让 AI 更加普及的使命。如果我们希望 AI 惠及世界的每一个角落,每一个行业,每一个应用,我们必须让 AI 更加实惠。实际上,早在今年5月14日,OpenAI推出可免费使用的全新旗舰AI模型GPT-4o。OpenAI首席技术官米拉·穆拉蒂 (Mira Murati)表示,GPT-4o里的“o”是Omni(全能模型)的缩写,可实时进行音频、视觉和文本推理,它可以在短至232毫秒、平均320毫秒的时间内响应音频输入,与人类在对话中的反应速度一致。米拉·穆拉蒂指出,在API使用方面,相比去年11月发布的GPT-4-turbo,GPT-4o价格降低一半(50%),速度提升两倍(200%)。OpenAI CEO奥尔特曼(Sam Altman)当时称,新的GPT-4o是OpenAI有史以来最好的模型,它很智能,速度很快,是原生多模态,并且GPT-4o语音助手可供包括Plus、免费版本在内的所有ChatGPT用户使用。然而,GPT-4o语音助手却意外地迎来推迟。今年6月22日,OpenAI宣布,原计划在6月下旬向一小群 ChatGPT Plus用户推出的GPT-4o语音功能,将推迟到7月,还需要一个月时间才能达到发布标准。至于原因,OpenAI称是因为需要更多时间进行安全测试。“我们正在提高模型检测和拒绝某些内容的能力,同时努力改善用户体验,并准备我们的基础设施扩展到数百万,同时保持实时响应。”OpenAI表示。![]()

如今,OpenAI似乎又重新调整,推出了小参数模型GPT-4o mini。而一般来说,这类小参数模型规模大约不到7B(70亿),可用于笔记本电脑、手机等端侧设备。具体来说,GPT-4o mini 在文本智能和多模态推理方面的学术基准测试中超越了 GPT-3.5 Turbo 和其他小型模型,并且支持的语言范围与 GPT-4o 相同。它还在函数调用方面表现出色,这可以使开发人员构建获取数据或使用外部系统采取行动的应用程序,并且与 GPT-3.5 Turbo 相比,它的长上下文性能有所提高。推理任务:GPT-4o mini 在涉及文本和视觉的推理任务上优于其他小型模型,在文本智能和推理基准 MMLU 上的得分为 82.0%,而 Gemini Flash 为 77.9%,Claude Haiku 为 73.8%。数学和编码能力:GPT-4o mini 在数学推理和编码任务中表现出色,优于市场上之前的小型模型。在测量数学推理的 MGSM 上,GPT-4o mini 得分为 87.0%,而 Gemini Flash 得分为 75.5%,Claude Haiku 得分为 71.7%。在测量编码性能的 Humaneval 上,GPT-4o mini 得分为 87.2%,而 Gemini Flash 得分为 71.5%,Claude Haiku 得分为 75.9%。多模态推理:GPT-4o mini 在多模态推理评估 MMMU 上也表现出色,得分为 59.4%,而 Gemini Flash 为 56.1%,Claude Haiku 为 50.2%。![]()

性价比方面,GPT-4o mini发挥优异。目前,GPT-4o mini 现已作为文本和视觉模型在 Assistants API、Chat Completions API 和 Batch API 中提供。开发人员每 100 万个输入令牌支付 15 美分,每 100 万个输出令牌支付 60 美分(大约相当于标准书籍的 2500 页)。OpenAI表示,这比之前的 Frontier 型号便宜一个数量级,比 GPT-3.5 Turbo 便宜 60% 以上。

OpenAI API 产品负责人 Olivier Godement 表示:“我们的使命是推动前沿技术的发展,打造最强大、最实用的应用程序,我们当然希望继续开发前沿模型,不断突破极限。但我们也希望拥有最好的小型模型。”OpenAI 发布 GPT-4o mini 之后,很多人最先关心的一个问题可能是:GPT-4o mini,相比 GPT-4 和 GPT-4o 用起来的表现如何?用一个例子来简单说明下,分别询问通过这三个模型询问 ChatGPT:「介绍下 OpenAI 最新发布的 GPT-4o mini 模型。」在生成结果上,GPT-4o mini 的回答并不包含任何数据,内容相对空洞,但相关描述基本正确。考虑到 OpenAI 指出 GPT-4o mini 只具有截至 2023 年 10 月的知识,且在 ChatGPT 中不支持联网,可以说明 GPT-4o mini 是从命名作出的「推测」。![]()

GPT-4o mini

相比之下,GPT-4(未经联网搜索)告诉我「OpenAI 并没有发布名为『GPT-4o mini』的模型」,直到主动要求联网搜索,才真正开始介绍。不过即便如此,GPT-4 还是没有明显超出 GPT-4o mini 生成的答案,就算明确问它「成本有多低」,也没能给出让人满意的答案。

![]()

GPT-4

至于 GPT-4o(自动联网搜索),作为目前 OpenAI 旗下甚至全世界最强大的模型,其表现毋庸置疑。更详略得当的介绍、更确凿的数据和引用链接,都让它能够继续稳坐大模型的头把交椅。![]()

GPT-4o

简单总结一下,GPT-4o mini 相比之前的 GPT-3.5 有着明显的进步,甚至相比 GPT-4 也有一定优势。虽然我目前的几个简单测试基本符合 OpenAI 和 LMSYS 排行榜给出的结论,但要下最终结论还是太早。如果大家有需求,后续可以做更全面的对比。Godement表示,过去一周,一些开发人员一直在试用GPT-4o mini。一家美国电邮初创公司Superhuman使用它来制作消息的自动回复,金融服务初创公司Ramp依靠它从收据中提取信息。另外,OpenAI还表示,GPT-4o mini 是该公司首个使用其开发的新安全策略(称为“指令层次结构”)的 AI 模型。这种方法的目的是让 AI 系统优先执行某些指令(例如来自公司的指令),从而使人们更难让该工具做不该做的事情。OpenAI 为什么要推出 GPT-4o mini?

对于 OpenAI 来说,推出 GPT-4o mini 是一件比较反常的事情,因为在此之前,从 GPT-1/2/3、GPT-3.5 到 GPT-4、GPT-4o,OpenAI 都是在推出更强的大模型,冲击机器智能的天花板。就算是 Turbo 系列,也是同等性能下优化速度和成本。但在 GPT-4o mini 上,OpenAI 选择了缩小模型规模、降低模型性能,以实现更具成本效益的生成式 AI 模型。问题在于,在 OpenAI 之前,很多大模型厂商从一开始就是「大中小模型」并进的策略,就算是谷歌 Gemini 和 Anthropic Claude,也都分别推出 Gemini 1.5 Flash 和 Claude 3 Haiku。对此,Olivier Godement 的解释是,OpenAI 专注于创建更大、更好的模型,如 GPT-4,这需要大量的人力和计算资源。不过随着时间的推移,OpenAI 注意到开发人员越来越渴望使用较小的模型,因此公司决定投入资源开发 GPT-4o mini,并于现在推出。![]()

简单来说,就是优先级的问题。但在优先级的背后,是越来越多公司偏好中小型的生成式 AI 模型。WSJ 近期的一篇报道,就援引多家公司高管以及 Google Cloud 全球生成式 AI 产品上市策略副总裁 Oliver Parker 指出,过去三个月,企业正在集体转向更小参数规模的生成式 AI 模型。实际上,当前,GPT-4o mini同性能下的小端侧模型赛道,估值800亿美金的OpenAI将面临着诸多竞争对手。其中,包括 Anthropic、谷歌等多个涉足于 AI 模型的公司,经常发布其最先进模型的更灵活、功能更少、成本更低的版本,比如Gemma-7B,以便为开发人员提供更多选择。而较小的模型可能在算力成本低的情况下实现最适合的基本任务,而较大的模型可能可以处理更复杂的任务。值得一提的是,就在今年7月,仅有8人的法国AI实验室kyutai发布首个实时原生多模态Moshi,仅用了半年的时间从头训练,效果演示堪比5月发布的GPT-4o,被誉为“开源版”GPT-4o。同在7月19日凌晨,Mistral Al发布12B的小模型,同英伟达合作开发,上下文长度为128K,迎来对战。而在国内,商汤早前发布国内首个所见即所得、实时流式多模态交互模型“日日新5o”,交互体验对标GPT-4o;科大讯飞董事长刘庆峰直言,讯飞星火大模型的语音效果也堪比GPT-4o。另外,7月16日左右,阿里云Qwen也公布了类似于GPT-4o的语音助手技术。另外CNBC评价称,GPT-4o mini是OpenAI 努力走在“多模态”前沿技术的一部分,即在一个工具 ChatGPT 中提供多种媒介类型(如文本、图像、音频和视频)下的生成式 AI 技术能力。中国企业家杂志提到,目前国内已有一部分大模型公司放弃了底层模型的更新探索包括投喂更多数据和尝试新算法,转向应用和场景探索。技术进化不重要,赚钱才是正经事。清华大学计算机系长聘副教授,面壁智能联合创始人、首席科学家刘知远强调,未来的 AI 大模型将是端云协同的模式。出于隐私保护、算力等考虑,把模型放在离用户更近的地方,具有重要的价值和意义。 本文链接:http://lechangxia.cc/gpt4/844.html

chatgpt提问模板GPT选股chatgpt4.0微软全家桶chatgpt开通会员会快一些吗chatgpt充值以后用不了购买ChatGPT账号注册chatgpt要提前准备哪些手机版chatgpt注册教程chatgpt注册被拒绝人工智能chatgpt4